Chcesz, żebyśmy zajęli się Twoim contentem AI?

Zostaw mail lub telefon. Odezwiemy się!

Generator obrazów Flux.1 AI – jak zacząć?

Grafiki AI zmieniają oblicze Internetu i otwierają nowe możliwości dla twórców, marketingowców i pasjonatów technologii. Wśród generatorów obrazów opartych na sztucznej inteligencji pojawił się właśnie nowy, obiecujący gracz – Flux.1 od Black Forest Labs.

W tym poradniku dla początkujących szczegółowo opiszę podstawowy workflow modelu Flux.1 Schnell oraz interfejsu użytkownika ComfyUI.

Co znajdziesz w tym artykule?

- Co to jest Flux.1?

- Wymagania sprzętowe

- Instalacja modelu Flux.1 Schnell / Dev – wskazówki

- Co to jest ComfyUI?

- Panel ComfyUI zasada działania

- Skąd pobrać workflow modelu Flux.1? krótka instrukcja.

- Podstawowy workflow Flux.1 Schnell ComfryUI

- Jak generować obraz za pomocą Flux.1 Schnell?

- Midjourney, a Flux.1

- Działanie Flux.1 z ComfyUI – podsumowanie

- Przykładowe obrazy Flux.1

Co to jest Flux.1?

Na wstępie nie mogę się oprzeć i nie podkreślić, że nowe modele AI, które będziemy dzisiaj opisywać pochodzą z Europy! Zacznijmy jednak od początku. Co to jest Flux.1?

Flux.1 to rodzina modeli, opracowanych przez Black Forest Labs, przeznaczona do tworzenia wysokiej jakości obrazów na podstawie opisów tekstowych (text-to-image).

Black Forest Labs to zespół w którego skład wchodzą postacie takie jak Robin Rombach, Patrick Esser oraz Andreas Blattmann, którzy wcześniej współtworzyli Stable Diffusion.

Siedziba firmy znajduje się w Niemczech, w malowniczym regionie Schwarzwaldu (Czarny Las, Black Forest).

Flux.1 w krótkim czasie zyskuje coraz większą popularność. Już wielokrotnie można było zauważyć nagłówki, że generator obrazów XX jest lepszy bądź równie dobry, jak Midjourney. Jako fanka Midjourney nigdy jednak nie mogłam zgodzić się z tym twierdzeniem. Wielokrotnie były to tylko clickbaitowe nagłówki.

Jednak tym razem jest inaczej. Flux.1 przyciągnął również moją uwagę i uważam, że jest bardzo dobrym konkurentem / alternatywą dla Midjourney. Do tego tematu wrócę jeszcze później.

Jak już wspominałam Flux.1 to rodzina modeli AI, w której skład wchodzą 3 modele:

Flux.1 Pro jest płatną wersją, profesjonalnych zastosowań, na przykład w marketingu, projektowaniu czy produkcji mediów. Model Pro dostępny jest przez API, działa na zasadzie pay-per-use, co oznacza, że użytkownicy płacą za każdy wygenerowany obraz.

Flux.1 Dev wersja modelu przeznaczona do użytku badawczego i niekomercyjnego. Flux.1 Dev jest otwartym modelem, co oznacza, że jest dostępny dla społeczności, umożliwiając deweloperom i badaczom eksperymentowanie z jego strukturą oraz implementowanie własnych rozwiązań.

Flux.1 Schnell jest najszybszym z modeli Flux.1. Dostępny na licencji open-source, dzięki temu jest idealnym rozwiązaniem dla szybkiego prototypowania, testowania oraz użytku osobistego.

Modele Dev oraz Schnell możemy uruchomić lokalnie na swoim komputerze, dzięki temu możemy generować obrazy za darmo.

Wymagania sprzętowe

Flux.1 Dev:

VRAM (pamięć karty graficznej): Minimum 12 GB VRAM, ale dla optymalnej wydajności zaleca się 16 GB lub więcej.

RAM: Co najmniej 32 GB pamięci RAM.

GPU: Zalecane jest użycie wysokiej klasy GPU, np. NVIDIA RTX 3090 lub lepszy, aby zapewnić płynne działanie.

Flux.1 Schnell:

VRAM: Minimum 12 GB VRAM.

RAM: 8 GB RAM

GPU: Model ten można uruchomić na bardziej standardowych GPU, ale dla lepszych wyników zaleca się GPU z co najmniej 12 GB VRAM.

Instalacja modelu Flux.1 Schnell / Dev – wskazówki

1. Zainstaluj ComfyUI – https://github.com/comfyanonymous/ComfyUI/releases

2. Pobierz wszystkie pliki Flux1 – https://github.com/black-forest-labs/flux

Co to jest ComfyUI?

ComfyUI to graficzny interfejs użytkownika (Graphical User Interface, GUI). Jest szczególnie popularny w społeczności open-source i służy jako narzędzie do pracy z różnymi modelami AI, takimi jak, np. Stable Diffusion, czy Flux.1.

Dzięki ComfyUI możemy eksperymentować z różnymi ustawieniami modelu i technikami generowania obrazów bez konieczności pisania kodu. Interfejs działa na zasadzie dodawania modułów, w łatwy sposób możemy stworzyć własną ścieżkę pracy (workflow) i pobierać już gotowe workflows udostępnione przez innych użytkowników modelu.

Panel ComfyUI zasada działania

Workflows tworzone są przy użyciu węzłów (nodes), gdzie każdy węzeł reprezentuje określoną operację, taką jak ładowanie punktu kontrolnego, stosowanie filtra lub generowanie obrazu. Węzły można łączyć w sekwencji, aby zdefiniować przepływ danych.

Przesuwanie, usuwanie i dodawanie węzłów sprawia, że w prosty sposób możemy testować różne parametry modelu.

Każdy workflow możemy zapisać, co pozwala na jego powtórne użycie w różnych projektach lub udostępnianie innym osobom. Jest to szczególnie przydatne w przypadku replikowania złożonych procesów generowania obrazów.

Jest to dobra wiadomość dla osób, które nigdy nie korzystały z ComfyUI. Gotowe workflow można załadować do interfejsu ComfyUI i możemy zacząć generować obrazy.

Skąd pobrać workflow modelu Flux.1? krótka instrukcja.

Wejdź na stronę https://comfyanonymous.github.io/ComfyUI_examples/flux/. Znajdziesz tam przykłady obrazów wykonanych przy użyciu modeli Flux.1. Te pliki PNG to specjalne obrazy, które zawierają wszystkie ustawienia potrzebne do uruchomienia danego modelu Flux.1 w ComfyUI.

Dla modelu Flux.1 Schnell będzie to ta grafika.

Zatem jeszcze raz, aby uruchomić podstawowy workflow dla modelu Flux.1 Schnell należy:

1. Pobierać odpowiedni przykładowy PNG ze strony https://comfyanonymous.github.io/ComfyUI_examples/flux/

2. Otworzyć ComfyUI na swoim komputerze

3. Przeciągnąć pobrany obraz do okna ComfyUI.

Po przeciągnięciu obrazu w oknie ComfyUI pojawi się workflow, który powinien wyglądać tak, jak ten opisywany w kolejnej części artykułu.

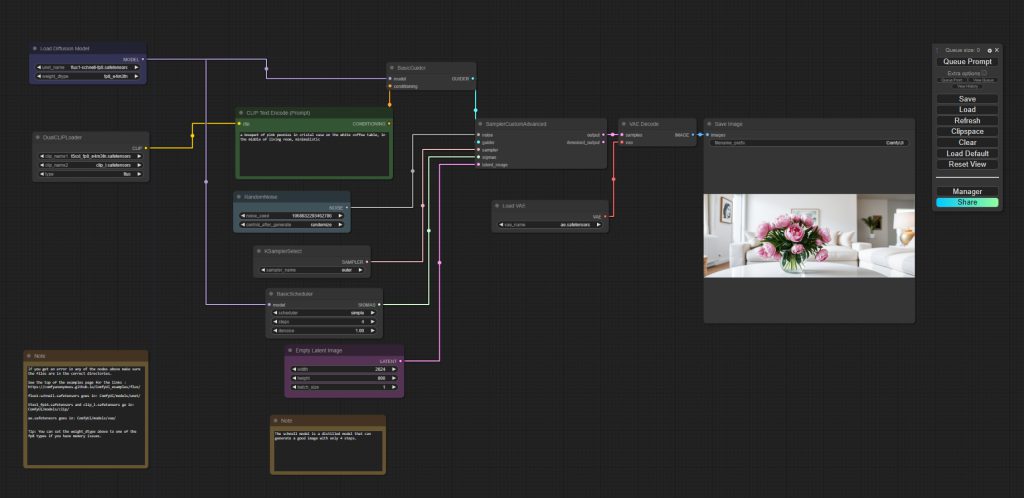

Podstawowy workflow Flux.1 Schnell ComfryUI

Przedstawiony poniżej workflow automatyzuje proces generowania obrazów na podstawie opisu tekstowego, przy użyciu modelu Flux.1 Schnell.

Dzięki ComfyUI proces jest przedstawiony wizualnie w prosty i przystępny dla użytkownika sposób. Każde okienko / komponent w przestrzeni roboczej ComfyUI to tak zwany node.

Każdy nod pełni swoją rolę w przetwarzaniu danych, od wczytania modelu, przez przetwarzanie tekstu i generowanie obrazu, aż po zapis gotowego pliku. Poniżej opisze i krótko wyjaśnię za co odpowiada każdy node w tym podstawowym workflow.

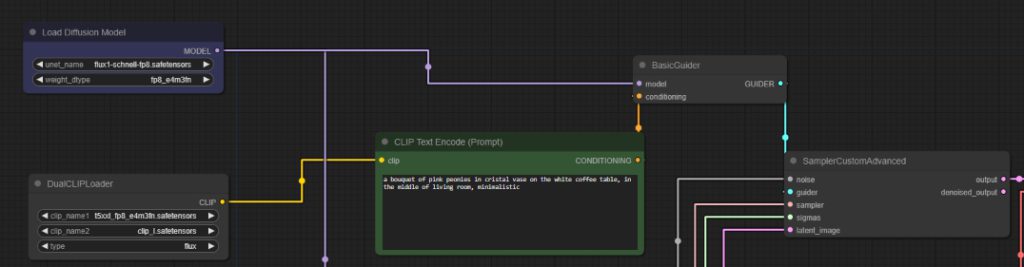

Node 1: Load Diffusion Model (Załaduj model dyfuzji)

Ten nod ładuje główny model, który będzie generował obraz. W tym przypadku ładowany jest model „flux1-schnell-fp8.safetensors”, który jest zoptymalizowaną wersją modelu dyfuzji dla szybszego działania.

Node 2: DualCLIPLoader (Ładowanie CLIP)

W tym kroku ładowane są dwa modele CLIP, które pomagają zrozumieć prompt. Modele CLIP konwertują tekst na reprezentację wektorową, którą model dyfuzji może zrozumieć.

Zatem CLIP to model, który łączy tekst z obrazem. Pomaga modelowi dyfuzji zrozumieć, co chcesz wygenerować na podstawie opisu tekstowego.

Node 3: CLIP Text Encode (Prompt) (Kodowanie tekstu za pomocą CLIP)

W tym miejscu wpisujemy prompt. Prompt ze screena to: „bouquet of pink peonies in crystal vase on the white coffee table, in the middle of the living room, minimalistic”.

Podczas procesu generowania w tym kroku model CLIP zamienia podany opis tekstowy na reprezentację, którą zrozumie model dyfuzji.

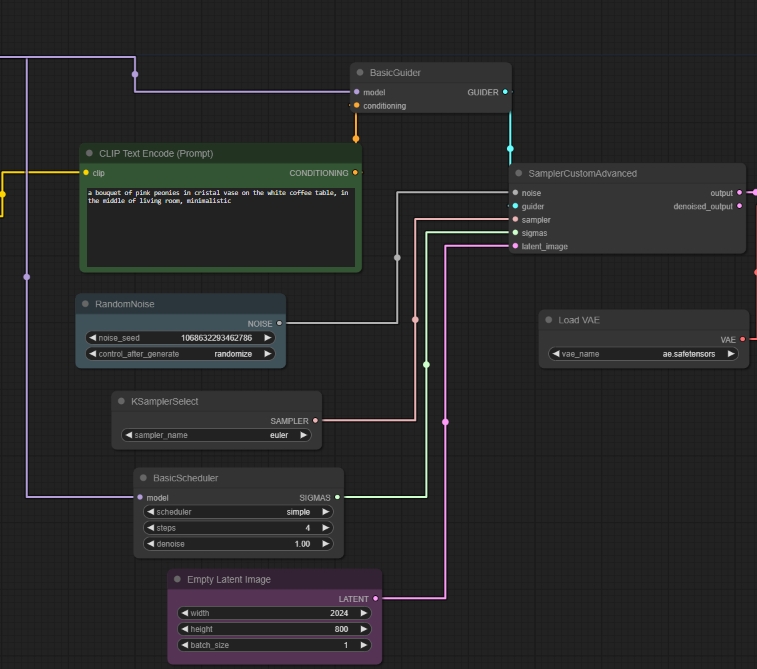

Node 4: RandomNoise (Losowy szum)

Ten nod generuje losowy szum, od którego model dyfuzji zaczyna swoją pracę. Proces dyfuzji zaczyna się od losowego szumu i stopniowo „odszumia” obraz, aby uzyskać docelowy wynik.

Node 5: KSamplerSelect (Wybór próbkowania)

Określa metodę próbkowania, która będzie używana do generowania obrazu. Tutaj wybrana jest metoda „euler”. Różne metody próbkowania mogą wpływać na to, jak szczegółowy i szybki będzie proces generowania obrazu.

Node 6: BasicScheduler (Podstawowy harmonogram)

Określa harmonogram, czyli jak długo i w jakich krokach model ma generować obraz. Ilość kroków wpływa na jakość wygenerowanego obrazu.

Node 7: Empty Latent Image (Pusty obraz latentny)

Tutaj wpisujemy wymiar obrazu jaki chcemy uzyskać.

Podczas pracy w tym kroku tworzony jest pusty obraz o wymiarach, na którym model będzie pracować. Możemy powiedzieć, że jest to płótno, na którym model zaczyna generować obraz.

Node 8: SamplerCustomAdvanced (Zaawansowany sampler)

Jest to główny nod, który łączy wszystkie elementy: szum, model, wybrane próbkowanie oraz VAE (który jest opisany niżej) do stworzenia końcowego obrazu. To w tym kroku następuje generowanie obrazu.

Node 9 i 10: Load VAE / VAE Decode

Te nody współpracują, aby najpierw skompresować, a potem przywrócić obraz, zapewniając, że jest on możliwie najwyższej jakości.

Najpierw Load VAE ładuje model VAE, który jest odpowiedzialny za kodowanie i dekodowanie obrazów. Proces kodowania polega na tym, że VAE przekształca obraz w formę latentną, czyli bardziej skompresowaną, abstrakcyjną reprezentację. Jest to niezbędne, aby model dyfuzji mógł efektywnie pracować z obrazem, koncentrując się na jego kluczowych cechach.

VAE Decode, po przekształceniu obrazu w formę latentną, ten nod używa VAE do odkodowania (dekodowania) obrazu z powrotem do jego pełnej, widocznej formy. Dzięki temu końcowy obraz jest bardziej szczegółowy i realistyczny, eliminując ewentualne rozmycia i błędy, które mogłyby pojawić się bez użycia VAE.

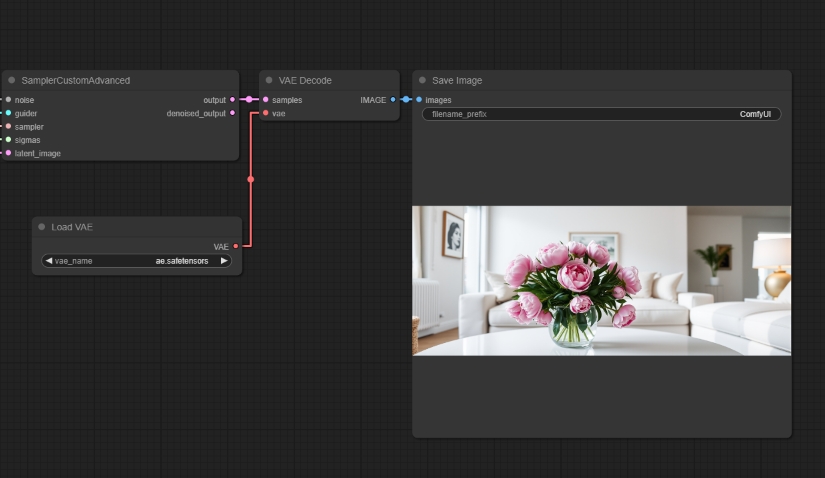

Node 11: Save Image (Zapisz obraz)

Zapisuje wygenerowany obraz na dysku twardym.

Jak generować obraz za pomocą Flux.1 Schnell?

Mam nadzieję, że udało mi się przybliżyć Tobie podstawowe zasady działania ComfyUI oraz znaczenie poszczególnych nodów w workflow Flux.1 Schnell.

Jeśli wydaje się Tobie to skomplikowane, nie martw się. Tak naprawdę, nie musisz znać znaczenia tych wszystkich kroków. Po otworzeniu gotowego workflow w ComfyUI możesz bezpośrednio generować obrazy.

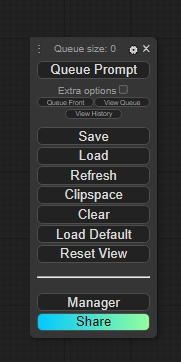

Wystarczy, że wpiszesz swój prompt w pole Node 3: CLIP Text Encode i klikniesz Queue Prompt w panelu menu.

Uzyskanie rezultatu może trwać kilkanaście sekund do kilku minut w zależności od parametrów Twojego komputera.

Screen panelu menu poniżej.

Podczas działania modelu poszczególne nody będą kolejno podświetlać się na zielono. Jeśli któryś z nich zaświeci się na czerwono będzie to oznaczało, że wystąpił błąd. Informacja o błędzie wyświetli się w panelu ComfyUI.

Cały proces możesz śledzić w wierszu poleceń, który automatycznie otwierany jest razem z interfejsem ComfyUI.

Midjourney, a Flux.1

Na wstępie chciałabym zaznaczyć, że możemy porównać tylko poszczególne aspekty tych dwóch generatorów obrazów AI. Mówienie o tym, że jakiś model jest najlepszy lub zastąpi inny, nie ma sensu. Choćby z tego względu, że każdy model będzie lepszy do innych zadań. Musimy wybrać rozwiązanie, które będzie odpowiednie do naszych celów i umiejętności.

Łatwość użytkowania

Pod względem interfejsu użytkownika, Midjourney oferuje intuicyjne, przyjazne dla początkujących środowisko, które umożliwia szybkie rozpoczęcie pracy bez potrzeby posiadania zaawansowanej wiedzy technicznej. Zwłaszcza, że przeglądarkowa wersja generatora, Midjourney Alpha, jest w końcu dostępna dla wszystkich użytkowników, bez względu na ilość wygenerowanych wcześniej obrazów na platformie Discord. Jeśli chodzi o Flux.1 musimy używać zewnętrznego interfejsu takiego, jak ComfyUI. Jego instalacja i obsługa jest bardziej skomplikowana.

Wymagania sprzętowe

Midjourney działa w chmurze, co oznacza, że użytkownicy nie potrzebują mocnego sprzętu komputerowego – wystarczy przeglądarka internetowa. Korzystanie z Flux.1 wiąże się z posiadaniem mocnego komputera o określonych parametrach.

Dostosowanie i elastyczność

Z kolei Midjourney ma ograniczone możliwości dostosowania i nie jest narzędziem open-source. Flux.1 oferuje znacznie więcej możliwości. Jest to narzędzie open-source, co oznacza, że użytkownicy mogą modyfikować i dostosowywać model do swoich specyficznych potrzeb. To czyni Flux.1 atrakcyjnym dla zaawansowanych użytkowników, którzy chcą mieć pełną kontrolę nad procesem generowania obrazów.

Koszt

Midjourney jest płatnym narzędziem działającym w modelu subskrypcyjnym. Flux.1, jako narzędzie open-source, jest dostępny za darmo. Choć wymaga więcej umiejętności technicznych oraz inwestycji w sprzęt, możemy generować dowolną liczbę obrazów i testować wiele możliwości.

Promptowanie i efekty

Zarówno dzięki Midjourney i Flux.1 możemy uzyskać wysokiej jakości, realistyczne obrazy. Jeśli chodzi o promowanie Flux.1 zdecydowanie lepiej radzi sobie ze złożonymi promptami i szczegółowymi instrukcjami. Jeśli podamy w prompcie, że niebieski stolik ma znajdować się po lewej stronie obok sofy, otrzymamy obraz z niebieskim stolikiem po lewej stronie sofy.

Midjourney zdecydowanie nie poradziłby sobie z taką instrukcją. Otrzymalibyśmy niebieski stolik i sofę, ale ich rozmieszczenie byłoby raczej randomowe. Natomiast oba modele radzą sobie świetnie z napisami.

Działanie Flux.1 z ComfyUI – podsumowanie

Od korzystania z Flux.1 dzielą Cię trzy kroki.

1. Sprawdzenie wymagań sprzętowych i przygotowanie komputera

2. Pobranie i instalacja modelu Flux.1

3. Instalacja interfejsu ComfyUI oraz pobranie workflow

Choć w pierwszej chwili wszystko może wydawać się skomplikowane to po stopniowym zapoznaniu się, już takie nie będzie. Pamiętaj, że do używania Flux.1 z Twojego komputera nie jest potrzebna znajomość kodowania.

Przykładowe obrazy Flux.1